Курсы Apache Airflow

Обучение по системе бизнес-аналитики Apache AirFlow

| 87 700 руб. | |

| Цена: | 65 000 руб. |

Преимущества продукта

Помимо открытого кода, важным преимуществом платформы является использование Python: все рабочие процессы создаются с помощью скриптов, написанных на этом языке. Сочетание этих характеристик продукта обеспечивает возможность неограниченного импорта библиотек и классов разработчиками, а также свободу использования любых типов рабочих процессов на разных этапах конвейера. Благодаря этому AirFlow – это не просто отличный планировщик, но еще и фреймворк для создания алгоритмов управления процессами планирования.

В дополнение к этому популярность AirFlow обеспечили следующие преимущества:

- определение ETL-процессов как кода, что дает возможность отказаться от использования JSON- или XML-конфигурационных файлов при создании описания пайплайнов;

- удобный продуманный интерфейс и обширный инструментарий. Пользователи могут работать с AirFlow, используя не только веб-интерфейс на базе Flask, но и с применением CLI или REST API;

- возможность интеграции с большим количеством ресурсов и сервисов, включая базы данных (PostgreSQL, MySQL, Apache Hive, DynamoDB), хранилища Big Data (HDFS, объектное хранилище S3), облачные сервисы (Google Cloud Platform, Amazon Web Services, Microsoft Azure), другие продукты Apache – Spark, Hadoop, а также MongoDB, Redis и др.;

- возможность кастомной настройки процессов и компонентов;

- собственный репозиторий, созданный с использованием библиотеки SqlAlchemy для хранения метаданных;

- отличная масштабируемость, достигаемая благодаря использованию модульной архитектуры, и возможность встраивания AirFlow в действующую корпоративную инфраструктуру с настройкой конвейеров данных;

- мониторинг данных в режиме реального времени и настройка сработки по ключевым событиям;

- высокий уровень безопасности с использованием различных уровней доступа и гибкой настройки доступа RBAC

- Возможность тестирования задач и пайплайнов.

Использование платформы

Применение Apache AirFlow решает целый спектр задач, связанных с управлением реализацией бизнес-задач, в том числе:

• организация тестирований;

• настройка обмена данными между системами и продуктами;

• разработка, проектирование и текущее обслуживание продуктов для обработки данных;

• мониторинг и планирование процессов работы с информацией.

Эти востребованные задачи в Airflow решаются применением следующих инструментов:

- разработка и запуск задач формата ETL и ELT (extract, transform, load - извлечь, трансформировать, загрузить) посредством python-скриптов;

- разработка моделей для машинного обучения;

- использование Track system;

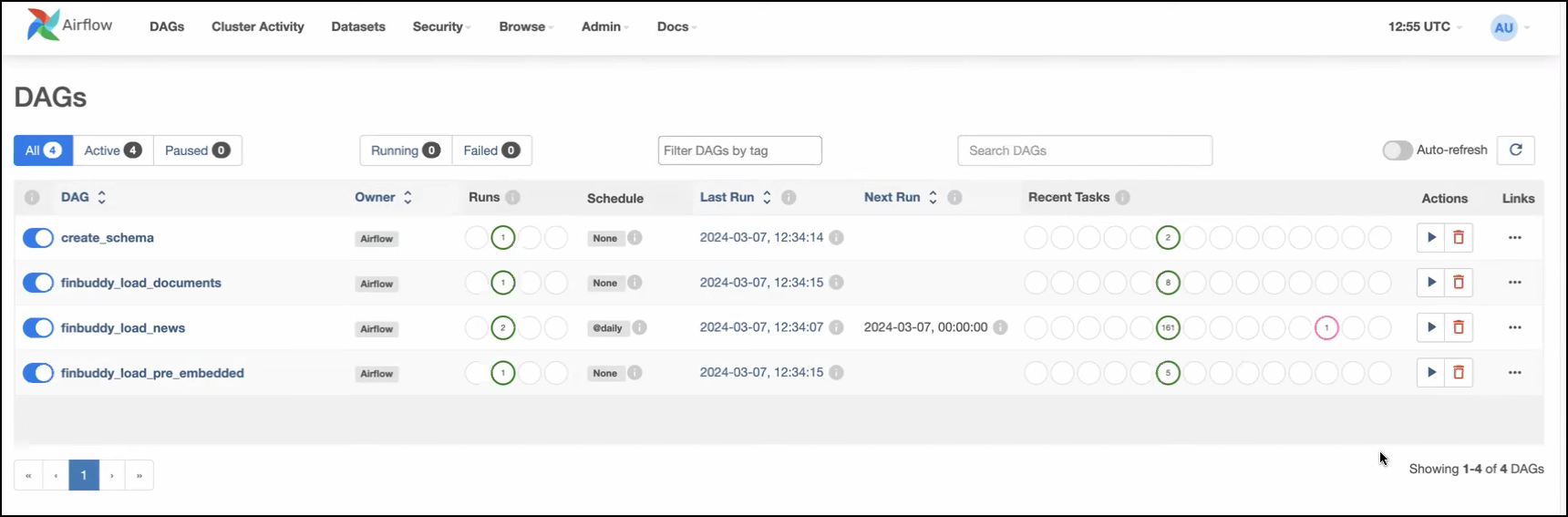

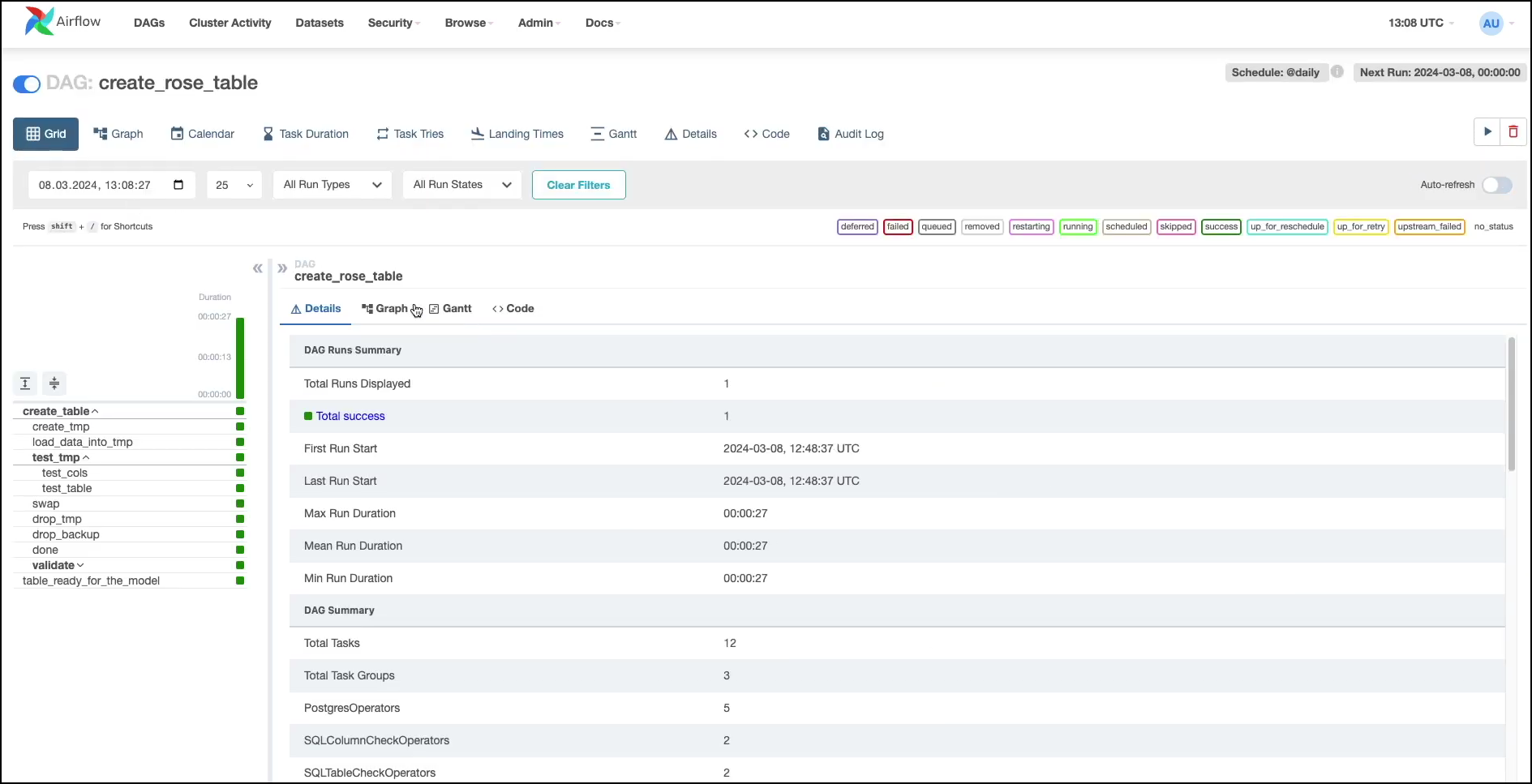

- формирование алгоритмов рабочих процессов посредством DAGs;

- запуск задач во внешних системах и управление их расписанием;

- организация взаимосвязей между рабочими задачами;

- создание отчетов;

- резервное копирование;

- другие инструменты.

Аудитория продукта

Широкие возможности применения AirFlow делают этот продукт востребованным среди разных категорий специалистов, которые с его помощью решают описанные выше задачи. Основными категориями целевой аудитории платформы можно назвать:

• инженеров данных (Data Engineer), которые отвечают за организацию корректной работы с потоками информации от баз данных, ресурсов Big Data, веб-серверов и файловых журналов до хранилищ данных. Эта информация потом используется для обработки, визуализации и принятия бизнес-решений;

• аналитиков данных (Data Analysts) и бизнес-аналитиков (BI Anaylsts), которые используют данные для обработки, выявления закономерностей, визуализации и построения отчетов для руководителей – они, в свою очередь, в зависимости от своих компетенций разрабатывают на этой основе бизнес-цели среднесрочного и долгосрочного характера;

• разработчиков и DevOps-инженеров, которые организуют тестирование приложений и систем, нуждаясь в корректном обмене данными между задействованными ресурсами;

• менеджеров проектов, которые занимаются планированием, организацией и мониторингом работы систем обработки данных.

Сейчас AirFlow востребован в таких отраслях экономики как сфера развлечений, IT, финансовые и банковские услуги, медиа, электронная коммерция, научные и маркетинговые исследования и проч. Наибольший интерес к продукту проявляют крупные компании, которые для обеспечения своей работы нуждаются в ежедневной обработке больших массивов данных. При этом работа с платформой требует достаточно серьезных навыков в области администрирования, использования языка Python, работы с внешними источниками и компонентами и т.д. Поэтому для полноценной работы с продуктом необходимы профессиональные навыки, которые можно получить только в ходе специального обучения. Вы можете пройти такое обучение в специализированном учебном центре АТТЭК.

Программа подготовки

Курс по Apache AirFlow в нашем учебном центре составлен с учетом актуальных потребностей рынка и наиболее востребованного инструментария платформы. При разработке программы мы опираемся на последний релиз системы и оперативно пересматриваем содержание курса при выходе обновлений. Благодаря этому наши выпускники всегда получают только актуальные знания, которые можно применять в работе сразу по окончании курса.

• Архитектура Apache Airflow

• Краткий обзор меню

• Основные термины и концепции – направленный ацикличный граф (DAG), subdag, конвейер данных (Pipeline), элементы выполнения операций (Operator), экземпляр задачи (Task Instance)

• Типы операторов – Action operators, Transfer operators, Sensor operators

• Основные компоненты - веб-сервер, планировщик, база метаданных, механизм запуска задач

• Инструментарий платформы - исполнитель (Executor), очередь исполнения (Queue), процесс выполнения задач (Worker), процесс поддержки отложенных операторов (Triggerer)

• Типы исполнителей

• Типы переменных – Variable, Connection, Secret, XCom

• Внешние интерфейсы для работы с различными сервисами – Hooks

• Обмен сообщениями или данными - XCom (кросс-коммуникация). Ограничения для XCom

• База данных PostgreSQL

• Учетная запись Gmail

• Учетная запись Google Cloud

• Контейнер Bucket в Google Cloud Storage

• Google Big Query

• Google Looker Studio

• VS Code

• Docker Desktop

• Виртуализация и включаемая подсистема Windows для Linux

• Роли доступа - Admin, Public, Viewer, Op, User

• Гибкая настройка доступа при помощи Role-Based Access Control

• Мониторинг работы системы

• Устранение неисправностей

• Обновление и техническая поддержка

• Процесс обработки AirFlow DAGs – схема совместной работы Sheduler, Workers и Webserver

• Алгоритмы выполнения задач

• Жизненный цикл задачи

• Статусы экземпляра задачи

• Представления DAG

• Минимальные системные требования – операционная система, база данных, хранилище сообщений, веб-сервер, объем оперативной памяти, процессор

• PostgreSQL

• Схема электроники

• Настройка Google Cloud Platform

• Настройка Big Query и Cloud Storage.

• Настройка AirFlow Docker

• Инициализация базы данных

• Сборка образов

• Схема архитектуры

• Этапы

• Задачи Big Query и Looker Studio

• Загрузка данных в базу данных

• Тестирование задач

• Обнаружение и устранение ошибок при работе с платформой

• Расширенные возможности аналитики, аналитические механизмы

• Интеграция со сторонними сервисами

• Дополнительные информационные ресурсы

• Предметное сравнение с другими инструментами обработки и визуализации данных

Организация обучения

Обучение по курсу Apache AirFlow ведут опытные преподаватели, которые сами имеют практический опыт работы с платформой в разных отраслях и готовы поделиться своими навыками и находками со слушателями. В нашем центре предусмотрены несколько форматов обучения:

- очно с выездом преподавателей;

- очно в учебном центре АТТЭК в Москве или Санкт-Петербурге;

- дистанционно на онлайн-платформе.

В рамках курса каждый слушатель получит доступ к большому объему информационных ресурсов, включающему:

• курсу лекций, охватывающему все аспекты работы системы;

• учебным массивам данных для освоения практических навыков работы с AirFlow;

• видеоматериалам, знакомящим обучающихся с нюансами работы в системе;

• комплекту учебных задач разного уровня, позволяющих научиться применять платформу в работе;

• разбору реальных кейсов успешного применения продукта;

• консультациям преподавателей по любым вопросам, связанным с использованием AirFlow.

Слушатели, окончившие курс, сохранят доступ ко всем материалам, предоставленным в ходе обучения. Благодаря этому они смогут в любой момент более детально изучить аспекты, которые требуются в работе.

Документ по окончании обучения

После изучения курса вам предстоит пройти финальный тест, по результатам которого оформляется удостоверение о повышении квалификации

Документ по окончании обучения

После изучения курса вам предстоит пройти финальный тест, по результатам которого оформляется удостоверение о повышении квалификации